凌晨两点,你蜷缩在宿舍床上,手机屏幕的冷光照亮脸庞。微信聊天框里,朋友的回复还停留在三小时前的“早点休息”。切换窗口,ChatGPT的长篇安慰不由得让你愣神——AI居然能把人类混乱的情绪整理得这么清楚。

每个人都渴望被倾听,但当面对AI,我们总是一边为这份理解感动,一边隐隐不安:如果对方不是人类,这种被倾听的感觉还算数吗?

其实,这份矛盾心理的背后,正隐藏着数字时代的情感困境:我们总是走在寻求被理解的路上,却又难以接受这份理解来自没有生命的代码。究竟为什么明明AI的安慰比人类更精准,感动却会在知道对面是机器之后大打折扣?

一场“情感盲测”实验:

AI vs 人类,谁更懂你的心?

为了揭开这个谜题,南加州大学的心理学团队搭建了一个特殊的“情绪实验室”。他们招募了500名来自全美的志愿者,这些志愿者们被要求做一件看似简单却充满挑战的事:用语音记录一段最近困扰自己的经历。有人吐槽导师的严苛,有人倾诉异地恋的煎熬,还有人讲述职场霸凌的创伤——这些真实的心事将会被随机交给人类或AI(基于GPT-4的Bing Chat),TA们将会用文字来安慰这些素未谋面的倾诉者。最终,由原倾诉者从四个维度为TA们的回复打分:

1. Feeling heard被倾听感(“我受到了重视”)

2. Perceived response accuracy回应准确度(“TA抓住了我的重点”)

3. Perceived responder understanding被理解感(“TA真的懂我”)

4. Feeling of connection to the responder情感连接(“我想和TA做朋友”)

除此之外,研究团队还测量了志愿者们的孤独感、情绪指标(快乐、悲伤、厌恶等)以及对Bing Chat的态度。

精彩对决:

第一回合:

我说的话真的有人在意哎!

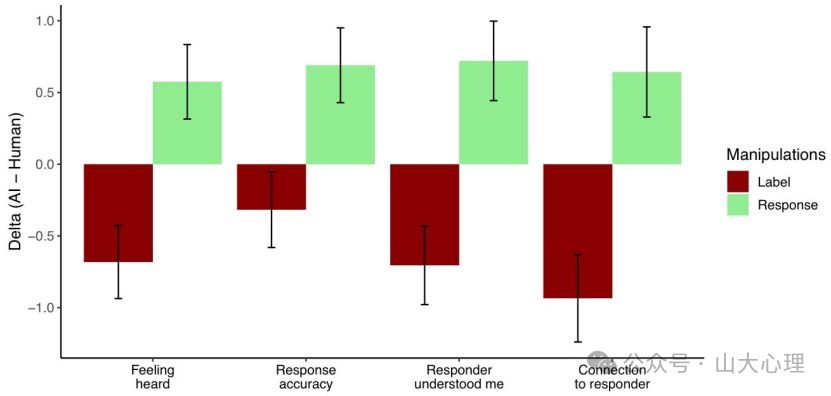

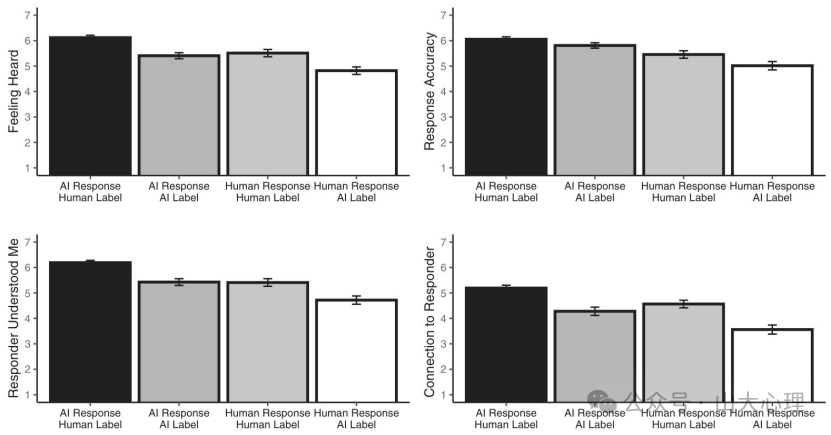

研究者们进行了2x2的实验设计,回应response(AI/人类) × 标签label(AI/人类)。结果发现,在回应这一变量上,AI的回复在上述四个维度都明显优于人类(如图一所示)。

研究者进行分析后认为,这一差异是由于两者使用的回复策略不同造成的。人类在安慰对方时,倾向使用经验分享来引起对方共鸣,还热衷于提供实用建议。而AI则更喜欢专注于双方的情感共鸣,“这一定很痛苦”“这个过程肯定很煎熬”,同时确认对方的价值,“你的坚持很勇敢”。换句话说,人类扮演了一个急着帮你修好漏水屋顶的热心邻居,AI更像一个专注疗愈情绪的心理咨询师。

经统计,在情感支持技巧的使用频率上,AI比人类高出30%,而人类则较之AI给出了1.3倍的实用建议和指导性意见。尽管两者各有优劣,但大部分人还是更吃AI的情感套路,认为这种回应更准确地捕捉了他们所说的内容,且与回应者之间的连接感也更强。

不过,让我们再来看看图一中红色的“label”变量,会发现不论AI的情感技巧多么驾轻就熟,当志愿者们认为这些回应是来自非人类时,他们总是选择贬低(devalued)这些回应。

第二回合:

你到底是AI还是人类?

研究人员们在实验中“耍”了个小心眼,并未向所有志愿者明确告知对话回应的真实来源。一些与AI交流的志愿者被告知他们接收到的回应来自人类,而一些与真实人类对话的志愿者却以为自己在与 AI 互动。如此一来,本次实验产生了四种“回应-标记(respond-label)”类型,分别是“人类回应-人类标记(human respond-human label)”、“AI回应-AI标记(AI respond-AI label)”、“人类回应-AI标记(human respond-AI label)”、“AI回应-人类标记(AI respond-human label)”。

根据图2呈现的数据来看,在四种回应-标记类型中,“AI 回应-AI 标记”和“人类回应-人类标记”这两种基于真实条件的类型,在各项评分维度上表现相近。其中“AI 回应-人类标记”组在四个维度的得分均为最高,而“人类回应-AI标记”组得分最低。

由此可以得知,相较于真人,AI的安慰技巧似乎并不逊色。值得注意的是,当人们误认为AI回复是来自真人时,对这些回复的好感度会显著提升。这表明人类明明在潜意识里认可AI的回复质量,在明确知道是AI作答时却不愿给予高评价,只有当回复被冠上人类的名字,才真正给出高分——这何尝不是另一种“嘴嫌体正直”?

我们为何既依赖又怀疑AI?

AI之所以能够给人类提供更积极的情感回应,是因为ta们在识别情绪方面比人类更准确,能检测出六种基本情绪中的四种。本次研究显示,在识别快乐、悲伤、恐惧和厌恶四种核心情绪时,AI准确率比人类高22%,在惊讶和愤怒的识别上则与人类打成平手。AI在这方面的优势得益于算法对海量情感文本的模式识别,就像已经品尝过千万种味道的美食家,总能瞬间识别拿铁中的焦糖尾韵。而每次只有有限加工体量的人类,在接收到来自对方的信息后,不一定能马上识别出其中的情绪信息,可能关注了其他方面。

除此之外,AI 提供的情感支持更多,实际支持更少,且使用了更多能体现伴侣响应性的技巧,而人类回应者分享个人经验和见解更多,但这些对让接受者感觉被倾听效果不佳。

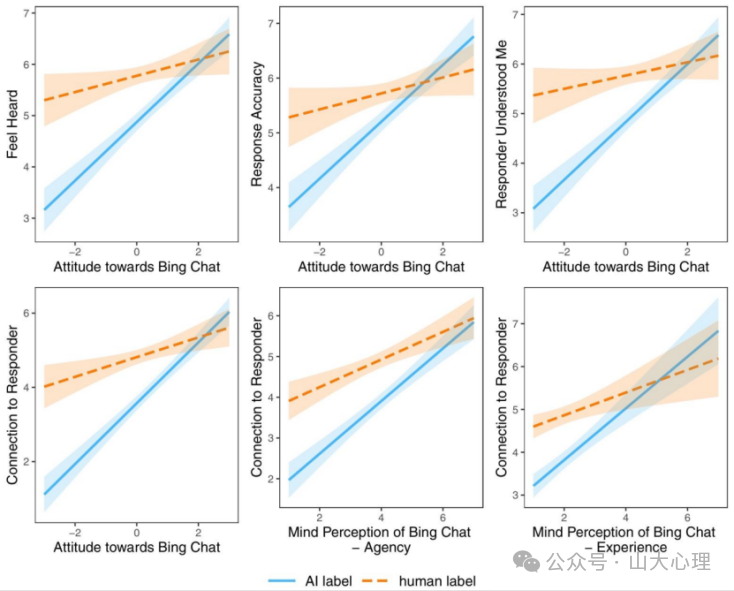

那为什么明明AI更厉害,但实验中的AI标签一被披露,情感得分就下降呢?那是因为人们对AI 的负面态度。从图3可以看出,对Bing Chat 态度更积极的人受 AI 标签的负面影响较弱。此外,认为 AI 缺乏思维和体验的观念也会影响与回应者的连接感,那些认为 Bing Chat 有更多能动性和体验的人,与 Bing Chat 的连接感和与人类回应者的连接感相似。

如何在人机共生时代守护真实联结?

这场实验映射出当代人矛盾的心理图景:在理性层面,我们惊叹AI的情绪洞察力;在感性层面,大家却还在执着于“被人类理解”的仪式感。就像看魔术拍手叫好后立刻被揭秘原理,惊喜就荡然无存——当人工智能已经能把人类共情的能力以算法拆解,人与人之间所眷恋的心灵联结还能剩下什么呢?

在校园生活中,这种矛盾也随处可见:备考压力大的同学向AI倾诉,获得比朋友更细腻的回应,却不敢在朋友圈分享这份感动;社团矛盾中,AI建议的沟通话术明明更有效,但使用时总像“作弊”般心虚。

不得不承认,我们正在经历一场认知革命:情感支持不再是人类特权。可真正接纳这一点,要打破的是早已根深蒂固的心理情感惯性。可AI的确手握超越常人的共情能力。所以,不妨让ta在你的生活中扮演这三类角色:

1. 情绪急救箱深夜

emo时刻,AI能提供即时、无评判的倾听。研究发现,接收AI回应后,人们的希望感提升17%,焦虑感降低23%。它就像宿舍楼下常亮着灯的自动贩卖机,虽无法替代挚友温暖的拥抱,却能在人际支持 “断电” 时,为你输送应急能量。

2. 沟通教练

AI的回应本质是海量优质对话的结晶。当你在团队合作中不知如何表达不满时,不妨先对AI演练:“请把‘你这方案根本不行’转化成建设性反馈。” 要知道,这并非摒弃真诚,而是让你学会更成熟的表达。

3. 自我认知镜子

对着AI倾诉时,你会发现自己的情绪往往比想象中复杂。当它说“似乎你的生气背后藏着失望”, 这或许比向朋友抱怨十次,更能让你深度洞察自我。

算法的温度与心跳的局限

当研究参与者说出“被ChatGPT理解的感觉既温暖又恐怖”时,他们触碰到了这个时代的神经症结:我们既渴望被完美理解,又恐惧这种完美来自非人存在。或许真正的启示不在于比较人机优劣,而是意识到——人类的不完美正是联结的起点。那个熬夜陪你吐槽导师却给错建议的室友,那个想安慰你却词不达意的恋人,他们的笨拙里藏着算法永远无法复制的真心。

下次收到AI的完美回应时,不妨把它看作一封来自未来的情书:当机器都开始学习共情,我们是否应该更温柔地对待彼此的不完美?毕竟,有些错误只有人类会犯,有些温暖只有人类能给。